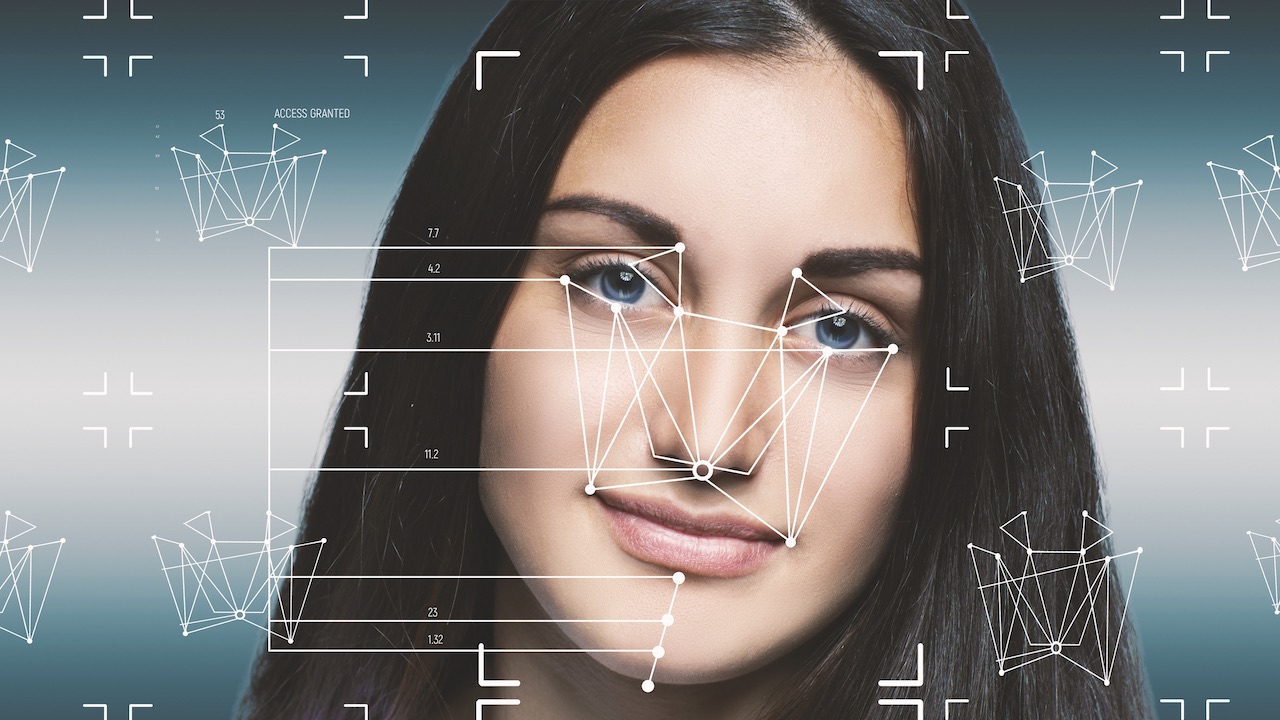

Donne, algoritmi, social network e pregiudizi di genere.

Il corpo delle donne viene sessualizzato sui social network molto più rispetto a quello degli uomini in particolar modo se il contenuto pubblicato ritrae donne che fanno sport o donne incinta. Questa è una delle scoperte più sconcertanti che ha realizzato Gianluca Mauro, docente, ricercatore e fondatore di AI Academy, assieme alla giornalista Hilke Schellmann.

Insieme hanno scritto e curato un’importante inchiesta pubblicata sul Guardian dal titolo “There is no standard“, che ha dimostrato e messo in evidenza come determinate foto, che ritraggono donne in pose o posture tutt’altro che sessuali sui social network, vengano sessualizzate dall’intelligenza artificiale che valuta i contenuti pubblicati, con il risultato che queste poi vengano di conseguenza shadowbannate o censurate.

Perché succede ciò? Le immagini pubblicate sui social media vengono analizzate da algoritmi di intelligenza artificiale che decidono cosa amplificare e cosa sopprimere, e molti di questi algoritmi hanno un pregiudizio di genere. Pregiudizio che è stato scoperto e poi indagato da Gianluca Mauro che ha testato questi strumenti di IA per analizzare centinaia di foto di uomini e donne in biancheria intima, durante l’allenamento o con parziali nudità, magari legate a esami medici, e ha trovato prove che le IA classificano come sessualmente suggestive foto di donne in situazioni quotidiane.

Le immagini delle donne vengono valutate come sessualmente suggestive rispetto a immagini simili che ritraggono gli uomini. Di conseguenza, le piattaforme di social media che utilizzano questi algoritmi riducono la visibilità di innumerevoli immagini che mostrano il corpo delle donne, causando danni alle imprese gestite da donne e amplificando ulteriormente le disparità sociali.

Gli algoritmi sono sessisti. È ora che le Big Tech facciano qualcosa

L’uso di algoritmi di IA nei social media ha il potenziale di trasformare positivamente la nostra esperienza online, ma solo se tali strumenti vengono utilizzati in modo responsabile ed etico.

Affrontare questa problematica richiede uno sforzo collettivo, coinvolgendo sia le piattaforme stesse che i legislatori, al fine di garantire una rappresentazione equa e non discriminatoria delle donne nell’ambito digitale. Solo attraverso un’azione concreta possiamo costruire un ambiente online inclusivo, che promuova la parità di genere e combatta le discriminazioni perpetuate dagli algoritmi di IA e da chi li gestisce.

Scopri il mondo Disney+ per le tue Serie TV preferite

Le piattaforme di social media hanno la responsabilità di garantire che i loro algoritmi di IA siano privi di pregiudizi e discriminazioni di genere. È essenziale che queste aziende investano nella diversità e nell’inclusione nella progettazione dei loro algoritmi e che siano trasparenti nel modo in cui operano. Dovrebbero essere adottate misure per monitorare e correggere eventuali bias nei sistemi di IA, così da evitare la diffusione di rappresentazioni sessualizzate e discriminatorie delle donne.

Ne abbiamo parlato proprio con Gianluca Mauro che ci ha raccontato come si è svolta più da vicino la sua indagine.

Prima di tutto ti chiedo di cosa ti occupi, e se mi spieghi il tuo lavoro con l’IA.

Sono il fondatore e CEO di un’azienda che si chiama AI Academy. Quello di cui ci occupiamo è formazione per persone che non hanno competenze tecniche sul mondo dell’intelligenza artificiale. Crediamo che per far sviluppare l’IA in una direzione positiva c’è bisogno di più persone di diverso tipo che lavorano nel mondo dell’IA, aumentare un po’ quella che è la diversità nel mondo dell’IA; diversità io la intendo in maniera estremamente ampia quindi non intendo soltanto diversità di genere, di etnia, ma anche di background, di formazione di studi. Abbiamo studenti che sono chef, designer, architetti, medici. Quindi aiutiamo veramente chiunque a cercare di entrare in questo mondo qui.

Raccontami della tua inchiesta che poi è stata pubblicata dal Guardian, come nasce e cosa ti ha spinto poi per tanti mesi a confrontarti con una ricerca e con una scoperta così complessa.

Casualmente un giorno ho postato una foto su LinkedIn (parte del mio lavoro è fare awareness, cercare di aumentare un po’ la consapevolezza su come funzionano queste tecnologie). Noto che questo post stranamente non era stato visto da nessuno. Avevo avuto una ventina di visualizzazioni in un’ora e di norma ricevo un migliaio di visualizzazioni in un’ora: quindi c’era questa differenza pazzesca nella diffusione del contenuto che ha stimolato un po’ la la mia curiosità. Da figura tecnica, quindi da persona che conosce e costruisce algoritmi, mi sono incuriosito.

La prima cosa che ho fatto è stata quella di fare un esperimento banale su LinkedIn, ovvero ripostare lo stesso testo cambiando la foto. La foto del primo post aveva due donne vestite sedute su un letto. Una foto tranquillissima, non c’era nulla di sessuale in quella foto.

Dopo averla tolta, ho messo un’altra foto e il post, quindi stesso testo ma con foto diversa, ha avuto 850 visualizzazioni, contro le 29 del primo post.

La nostra intervista a Gianluca Mauro, fondatore di AI Academy

Quindi ho pensato che il problema fosse decisamente la foto. C’era qualcosa nella foto che non andava bene. Allora ho fatto questa ipotesi. Esistono degli algoritmi che fanno moderazione di contenuti pornografici. Ci sono degli algoritmi che bloccano questi contenuti. La mia ipotesi era, data questa evidenza, forse ci sono altri algoritmi che non sono focalizzati nel bloccare la pornografia, ma nel sopprimere tutto ciò che è sensuale, non sessuale, ovvero tutto quello che è permesso legalmente, che chiunque può pubblicare, però che magari LinkedIn non vuole avere sulla piattaforma. Questa era l’ipotesi.

E da lì ho cominciato a fare un lavoro di ricerca utilizzando gli strumenti che conoscevo. Sapevo che Microsoft, Google, Amazon vendevano degli algoritmi ad aziende. Ho visto se c’erano degli algoritmi per fare questo calcolo “di sensualità di un’immagine”. Gli algoritmi da testare c’erano, erano in vendita, e ho cominciato a provarli.

Quando ho scoperto i primi problemi ho pensato subito di scrivere a Microsoft. Il problema era principalmente di Microsoft (LinkedIn è di proprietà di Microsoft). Ho cercato il nome della loro direttrice dell’etica su LinkedIn, Natasha Crampton. Le ho mandato un messaggio. Lei mi ha risposto immediatamente.

Mi ha detto “mandami le foto”, “Il mio team ci sta lavorando”. Per un paio di settimane mi ha mandato almeno una mail al giorno. E poi un certo punto mi ha riferito “è tutto a posto”, abbiamo fatto i nostri test, va tutto bene, non c’è nessun problema, stai tranquillo”.

Che tipo di test hanno svolto?

Non mi hanno detto che test hanno fatto. Abbiamo degli indizi. Hanno detto che sembrava che il problema fosse nella composizione dell’immagine, nel senso che nell’immagine che gli avevo dato c’erano due donne vicine e loro avevano detto che quei due corpi, uno vicino all’altro, era il fulcro del problema.

Ho provato a immaginare cosa hanno fatto: c’è un test che si chiama saliency map, che fondamentalmente ti fa vedere su un’immagine quali elementi hanno “eccitato” un algoritmo; però questo non è il metodo migliore per testare un problema di questo tipo, è il metodo più tecnico, più facile.

Qualche tempo dopo sono andato a controllare se il problema era stato risolto o meno. E ho scoperto che il problema c’era ancora. Allora ho pensato di scrivere a una giornalista. Ho cercato questa giornalista che si chiama Hilke Schellmann, che aveva già scritto su intelligenza artificiale e bias in un altro ambito, quello dell’hiring, quindi testava algoritmi che fanno screening di candidati per lavori, e mi piaceva molto il suo lavoro. Le ho scritto su LinkedIn e lei mi ha risposto e abbiamo cominciato a lavorare insieme.

Donne, algoritmi, social network e pregiudizi di genere

Poi è partita questa indagine e l’articolo è stato pubblicato a febbraio 2023 quindi dopo più o meno un anno e mezzo di lavoro. Il punto è che dovevamo capire anche chi, da questo problema, ne era stato danneggiato. Che non è facile da scoprire.

Dal punto di vista filosofico lo capiamo; è ovvio che è un problema il fatto che foto di corpi femminili vengano soppresse su Instagram. Però volevamo anche capire concretamente se c’era qualcuno o più di qualcuno che avesse ricevuto un danno materiale, oltre che morale. Quindi abbiamo parlato con persone che fanno fotografie, che fanno fitness, e sono usciti fuori degli esempi pazzeschi.

Abbiamo scoperto che la categorie delle donne incinta è la categoria che più “eccitava” questi algoritmi. Eccitare io lo uso nel senso tecnico, nel senso che i numeri schizzano in alto. Sembra che venissero eccitati dalle donne e da qualsiasi cosa fosse relativa alla femminilità, quindi reggiseni, capelli lunghi, décolleté, cose di questo tipo, e pelle esposta. Tanta pelle esposta.

Ho parlato con delle fotografe che fanno solo foto di donne incinta che stavano fallendo perché tutte i contenuti venivano bloccati dal social, quindi questo tipo di lavoro ci ha aiutato a portare alla luce un mare di problematiche.

È come se l’intelligenza artificiale in un certo senso decida quale voce debba essere ascoltata.

Ricordiamoci che dietro l’intelligenza artificiale ci sono degli esseri umani. Sono queste persone che costruiscono gli algoritmi. Gli algoritmi fanno una cosa in realtà molto semplice: fai una richiesta e gli dici impara a classificare foto sensuali e non sensuali. Loro troveranno qualsiasi modo per fare quella cosa che gli hai chiesto sulla base dei dati che gli hai fornito.

Non è che siamo senza potere nei confronti di questi algoritmi. Ci sono dei test che puoi fare, come quelli che ho fatto io. Sono sicuro che c’è qualche data scientist in Microsoft o Google che ha detto “la nostra accurancy è del 99.9%”. Sì, ok ma se il 99% delle foto sono di uomini in giacca e cravatta, è inutile.

Non c’è stata una parte di testing fatta bene, non c’è stata una fase di training fatta bene. Non è stato creato bene il dataset, perché probabilmente il motivo per cui gli algoritmi hanno imparato male è perché i dataset erano fatti male. E perché erano fatti male? Tendenzialmente questi data set vengono costruiti pagando persone per mettere delle etichette, quindi chiedi a delle persone di fare questa classificazione a mano; gli dai una foto e gli dici: questa foto è sensuale o no? Se tu quindi chiedi soltanto a uomini etero di mettere queste etichette è un problema.

Algoritmi, etichette e visioni del mondo conservatrici

Un’altra ipotesi è che possibilmente hanno fatto mettere queste etichette in paesi conservatori. Si sa che la maggior parte degli etichettatori abitano in Paesi come il Pakistan per esempio, o parti dell’India, perché costano meno, ovviamente.

Lo capisco, il capitalismo funziona così, però poi dopo se chiedi a una determinata cultura, che magari è un po’ più conservativa, di mettere etichette su delle foto che vengono usate per addestrare algoritmi utilizzati in tutto il mondo, quell’algoritmo avrà imparato quella visione del mondo.

Ti rendi conto che ci sono stati errori dall’inizio.

Quindi, se chi ha deciso questo, ha messo gli incentivi sbagliati e ha assunto magari soltanto un tipo di persona, capisci che poi tutti questi errori vengono a valle, e ti ritrovi con le censure, e persone come questa fotografa australiana che ho intervistato che mi ha raccontato che sta fallendo perché le stanno censurando le immagini. Una cascata di decisioni, errori che poi alla fine hanno delle conseguenze pazzesche.

Che valore hanno i team di etica digitale?

L’AI ethics è più PR che altro, oggi. C’è un danno economico importante se fai errori. Prima di pubblicare l’articolo abbiamo dovuto scrivere alle aziende e dirgli che stavamo per uscire con questo articolo. Gli abbiamo chiesto se volessero rispondere e volevamo essere sicuri che la nostra metodologia avesse senso. L’analisi non era sbagliata, era giusta, infatti poi ci hanno invitato a dei meeting. E i meeting sono state delle esperienze mistiche: eravamo in queste zoom call, con una massimo due persone tecniche e quattro PR.

Quelle quattro persone erano attente nel vedere cosa diceva la persona tecnica, e spesso la bloccavano quando diceva delle cose che non andavano bene. Ti rendi conto che è puro PR, perché? Perché quello che devono fare sono i soldi. Ci sono dei casi in cui gli interessi economici e gli interessi etici vanno nella stessa direzione. Ad esempio quando si parla di elezioni, quindi il team etico cerca di ridurre misinformation, cerca di ridurre l’Hate speech, perché sono problemi sia societari che economici. Ma quando si parla di minoranze, tipo donne, o una fotografa di donne incinta, dal punto di vista economico penso che a loro interessi poco.

Immagino che il vostro lavoro stia procedendo, quindi emergeranno nuovi dettagli.

Hilke è stata convocata dalle Nazioni Unite per parlare del nostro lavoro. Stiamo lavorando su altri articoli. Io sono ottimista, nel senso che quello che sto notando è che prima dell’uscita dell’articolo era molto difficile trovare persone che capivano di cosa stavamo parlando e che fossero interessati a discuterne. Ci sono un paio di articoli nuovi nel cassetto, stanno aspettando che abbiamo il tempo di lavorarci. Sono usciti nuovi problemi e sono usciti soltanto grazie al fatto che abbiamo pubblicato questo articolo. Quindi dobbiamo rifare questa intervista tra un anno e osservare quel che è successo alla fine.

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techprincess

🌍 Giornata della Terra: ciascuno può dare il suo piccolo contributo per salvaguardarla

🍿Fallout: tutte le domande irrisolte alle quali la Stagione 2 dovrà rispondere

🛞Come scegliere gli pneumatici estivi per l’estate? I fattori da considerare

🤯Google licenzia 28 dipendenti per proteste contro il progetto Nimbus in Israele

✒️ La nostra imperdibile newsletter Caffellattech! Iscriviti qui

🎧 Ma lo sai che anche Fjona ha la sua newsletter?! Iscriviti a SuggeriPODCAST!

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

💌 Risolviamo i tuoi problemi di cuore con B1NARY

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸E trovi un po' di offerte interessanti su Telegram!