Il deepfake rivoluzionerà il mondo del cinema. O, almeno, proverà a risolvere uno dei suoi più annosi problemi: quello del doppiaggio.

Gli spettatori più attenti, durante la visione di un film tradotto, mostrano insofferenza nell’accorgersi che le battute non corrispondono (come è ovvio) al labiale degli attori. Quando poi il doppiaggio è mediocre, e per fortuna è un caso che non si verifica quasi mai in Italia, spesso i dialoghi sono addirittura fuori sincrono.

Ma in futuro prossimo la tecnologia TrueSync potrebbe appianare questo piccolo (ma non per tutti piccolo) inconveniente.

Che cosa è il deepfake

Prima di scoprire il rapporto tra deepfake e cinema, che presto potrebbe diventare davvero stretto, è bene ricordare cosa sia il deepfake.

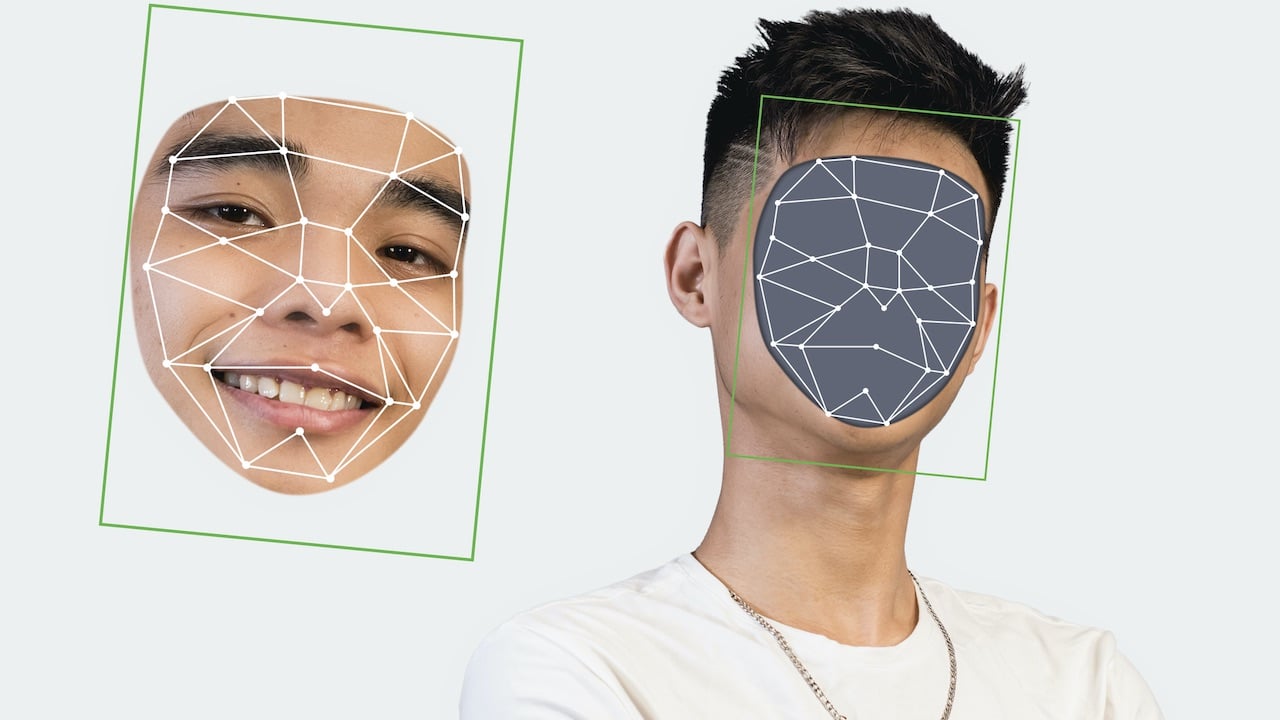

Si tratta di una tecnica per la sintesi delle immagini basata sull’intelligenza artificiale. Sovrapponendo diversi video e immagini (facciali e corporee), il deepfake ne crea altre, che solitamente vengono utilizzate con intenti satirici. O, nei casi peggiori, a fini ricattatori (pensiamo al deepfake usato per il revenge porn), per creare disinformazione (fake news), oppure per compiere atti di pirateria informatica o cyberbullismo.

Il futuro del deepfake

Perché il binomio deepfake-cinema funzioni, la qualità della tecnologia dovrebbe migliorare. Secondo Hao Li, uno dei massimi esperti mondiali in materia, entro un anno il deepfake farà un grande balzo in avanti.

“Secondo me ci vuole meno di un anno per sviluppare uno strumento che usi i nuovi algoritmi per produrre umani fotorealistici in ogni situazione. Di fatto la tecnologia già esiste, bisogna solo capire se qualcuno si sta impegnando a costruire l’applicazione che la sfrutti”.

Hao Li indica poi tre campi di applicazione per il deepfake di domani: gli ologrammi (in sostituzione delle videoconferenze), gli assistenti digitali e, appunto, il cinema.

Deepfake e cinema

Ed eccoci dunque arrivati al deepfake applicato al cinema.

Il primo utilizzo del deepfake nell’universo del cinema può portare a far dire o fare a personaggi più o meno famosi cose che in realtà non hanno mai detto o fatto.

Da qui all’utilizzo distorto della tecnologia, come abbiamo già notato, il passo è purtroppo breve. Finché si mette in bocca a un vip una frase scherzosa che diventa meme, il danno è relativo. Ma quando si adopera il deepfake per, ad esempio, pubblicare filmati porno sovrapponendo al volto reale quello di chi si vuole ricattare pubblicamente, il discorso cambia.

Gli attori, peraltro, non vedono di buon occhio gli ultimi approdi del tech, che potrebbero limitare il loro impiego o minare in qualche modo la loro serietà professionale.

Ora, però, il deepfake nel mondo del cinema ha bussato alla porta dei doppiatori.

Deepfake e cinema: verso un nuovo doppiaggio

L’idea è quella di utilizzare il deepfake al servizio del cinema non per creare sketch comici o irriverenti, ma per risolvere un limite della settima arte: quello del doppiaggio.

L’azienda in questione, una startup britannica con sede a Londra, si chiama Flawless. E il suo obiettivo è in fondo quello a cui più in generale tende tutta la tecnologia applicata agli spettacoli audiovisivi: aumentare il più possibile il realismo dei prodotti.

Realizzare film e serie TV che risultino naturali in ogni lingua farebbe crescere il grado di immedesimazione degli spettatori, e aggiungerebbe un senso di familiarità alle pellicole, ovunque esse siano proiettate.

In Italia, si sa, abbiamo una delle migliori scuole di doppiaggio del mondo. Fior di attori hanno prestato e prestano le loro voci ai più noti beniamini internazionali. Cadenze, accenti e inflessioni sono resi alla perfezione, e anche da un sospiro fatto ad arte può trasparire lo stato d’animo di un certo personaggio.

Ma il diaframma del mancato sincrono tra audio e labiale, nelle versioni tradotte, sino a oggi sembrava un limite invalicabile.

- Schick, Nina (Autore)

La tecnologia TrueSync

Il progetto di Flawless, fondata dal regista Scott Mann (che ha girato pellicole come Bus 657 e Final Score), si basa su una tecnologia chiamata TrueSync.

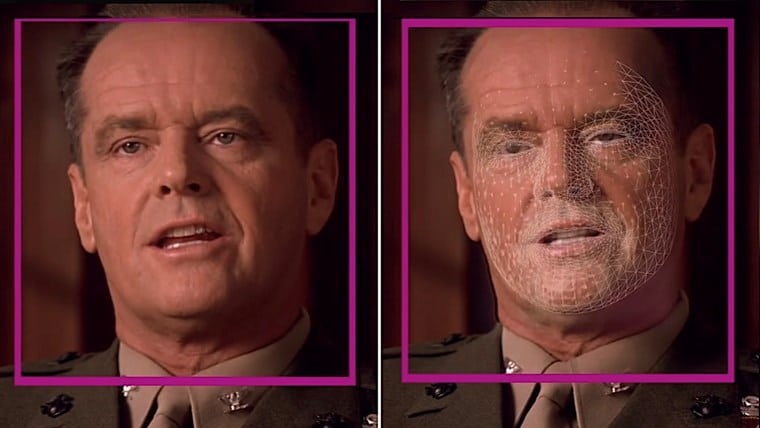

Sviluppata partendo da un progetto creato da alcuni ricercatori tedeschi del Max Placnk Institute, TrueSync poggia su un algoritmo capace di leggere la posizione di labbra e testa e il movimento degli occhi degli attori.

La seconda parte dell’operazione è la più complicata: modificare le espressioni in base alla lingua di destinazione, mantenendo inalterato il resto dell’inquadratura.

Oggi, ha dichiarato Mann, per doppiare una pellicola con la tecnologia TrueSync occorrono circa due mesi e mezzo. E i primi brevi video pubblicati da Flawless mostrano ancora movimenti non del tutto naturali.

Ma se le previsioni di Hao Li sulla prossima evoluzione del deepfake sono corrette, il cinema potrebbe davvero fare presto un passo da gigante sul fronte del realismo.

A quel punto, però, ci troveremmo di fronte a un bel paradosso: vogliamo davvero che un maggiore realismo derivi… dall’intelligenza artificiale? Desideriamo davvero che Robert De Niro ci parli in italiano, sapendo che quelle che vedremo non saranno le sue mitiche, inimitabili smorfie originali?

Leggi anche: Riconoscimento facciale o Deep Fake?

Ultimo aggiornamento 2024-10-06 / Link di affiliazione / Immagini da Amazon Product Advertising API

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techprincess

🎮 Che impatto avranno le elezioni americane sui videogiochi?

🚘 I gadget più strani delle case automobilistiche

🇨🇳 Un gruppo di ricercatori cinesi ha sviluppato un modello di IA per uso militare basato su Llama di Meta

🔍 ChatGPT si aggiorna e ora naviga sul web

Ma lo sai che abbiamo un sacco di newsletter?

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸E trovi un po' di offerte interessanti su Telegram!