Dopo 7 anni di sensori da 12 megapixel Apple è pronta a cambiare.

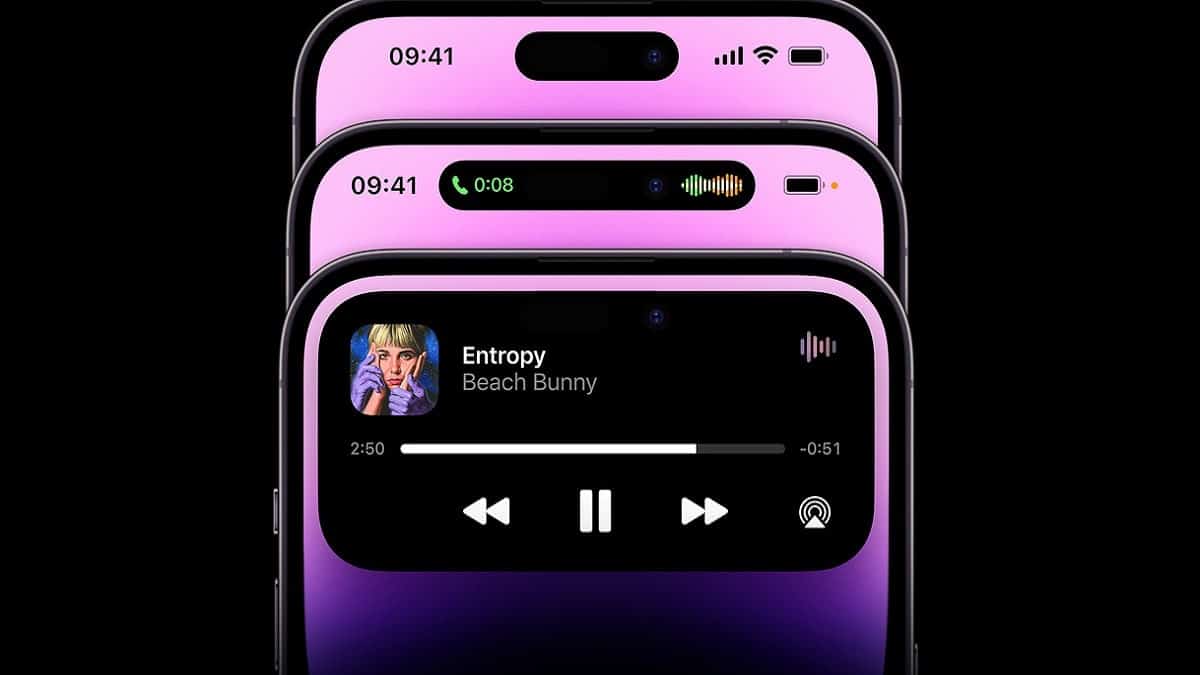

iPhone 14 Pro e Pro Max, in arrivo in autunno, dovrebbero montare una fotocamera principale da 48 megapixel. Naturalmente non sarà l’unica novità presente sugli smartphone della Mela, che verranno dotati del processore A16 Bionic e che dovrebbero sfoggiare finalmente un doppio forellino invece dell’ingombrante notch degli ultimi anni, ma le innovazioni che riguardano il comparto fotografico sono quelle che da sempre attirano maggior attenzione. A maggior ragione questa volta, visto che l’azienda di Cupertino è sempre stata paladina dei sensori da 12 MP.

Perché 12 megapixel?

Negli ultimi anni gli smartphone Android ci hanno sorpreso con sensori dalla risoluzione enorme. Basta pensare a quello da 108 megapixel che oggi troviamo su Samsung Galaxy S22 Ultra.

Perché quindi Apple ha scelto di rimanere ancorata ai 12 MP? Semplice: perché bastavano.

Aumentare i megapixel non comporta automaticamente una miglior qualità. Anzi, quando non viene fatta una corretta ottimizzazione software tutto ciò che otteniamo è un aumento del peso delle immagini.

La società guidata da Tim Cook ha preferito quindi continuare con il medesimo sensore lavorando però su tutto il resto e dando vita ad un camera phone che, ancora oggi, è molto difficile da battere o da eguagliare.

Quindi perché iPhone 14 Pro passa a 48 megapixel?

Beh, perché è il momento giusto.

Un sensore da 48 megapixel consentirà ad Apple di supportare la registrazione di video in 8K. Oggi potrebbe sembrarvi una feature inutile. Insomma, dove posso mai godermi un video con questa risoluzione? Il display dello smartphone è piccolo, i monitor dei PC sono tendenziale 4K o Full HD e i televisori 8K già presenti nelle case dei consumatori sono pochissimi. Vero, ma Cupertino pensa sempre al futuro e un iPhone è destinato a durare anni quindi perché non iniziare a supportare questa funzionalità?

Anche le foto possono trarre beneficio da un sensore di questo genere. Come? Grazie al pixel-binning, una tecnica che unisce più pixel per crearne uno più grande. Questo aiuta a catturare più luce e a più dettagli.

Infine è possibile mimare uno zoom semplicemente con un crop della foto catturata dal sensore principale. Google, con il suo Pixel 6, è una vera maestra di quest’arte. In sostanza invece di zoomare effettivamente, la foto viene scattata con il sensore più grande e poi tagliata per ottenere l’ingrandimento che vi interessa.

Voi ovviamente non vi accorgete di nulla ma beneficiate dei risultati, quindi di foto più nitide, definite e cromaticamente accurate.

Naturalmente questa è la teoria. Per scoprire come Apple implementerà effettivamente il nuovo sensore dovremo attendere il lancio ufficiale.

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techprincess

🇺🇸 Cosa ci aspettiamo dal CES 2025

🛍️ Quale iPad comprare a fine 2024?

🎶 I migliori 10 album internazionali del 2024

🕹️ 5 videogiochi da giocare a Natale

📰 Ma lo sai che abbiamo un sacco di newsletter?

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸E trovi un po' di offerte interessanti su Telegram!