L’intelligenza artificiale sta ponendo le basi della tecnologia di nuova generazione ed essendo una situazione nuova e piena di pericoli, c’è bisogno che venga regolamentata. Per questo motivo, i Paesi del G7 si sono riuniti e hanno stilato un codice di condotta che le aziende dovranno seguire durante lo sviluppo dell’intelligenza artificiale.

L’intelligenza artificiale regolata da un codice di condotta

I Paesi del G7 hanno istituito un codice che permette la regolamentazione dell’utilizzo dell’intelligenza artificiale da parte delle aziende. L’obiettivo è quello di limitare i rischi e l’abuso che tale tecnologia può causare. La legge verrà chiamata AI Act e prevede, appunto, il corretto utilizzo dell’intelligenza artificiale.

In cosa consiste il codice di condotta sull’intelligenza artificiale

Il codice di condotta sull’intelligenza artificiale, chiamato AI Act, è frutto del lavoro dell’AI Hiroshima Process. Prevede 11 punti che le aziende dovranno rispettare per assicurare sicurezza e trasparenza nello sviluppo della nuova tecnologia.

Innanzitutto, l’AI Act invita le aziende a mettere in atto misure giuste per identificare, valutare e mitigare i rischi durante tutto il ciclo di vita dell’intelligenza artificiale. Così come a trovare soluzioni per eventuali incidenti e uso improprio della tecnologia, dopo il lancio dei sistemi IA sul mercato.

Ma non solo. È fondamentale che le aziende stilino un report su capacità, limitazioni, uso e abuso dei sistemi IA. Il report, che verrà poi pubblicato, dovrà contenere anche la cifra di quanto l’azienda ha investito in controlli di sicurezza robusti. Vera Jourova, Vice Presidente della Commissione europea, ha dichiarato che il codice di condotta rappresenterà una base solida per garantire la sicurezza e farà da ponte fino all’approvazione dell’AI Act.

AI per le aziende: il rischio della sicurezza

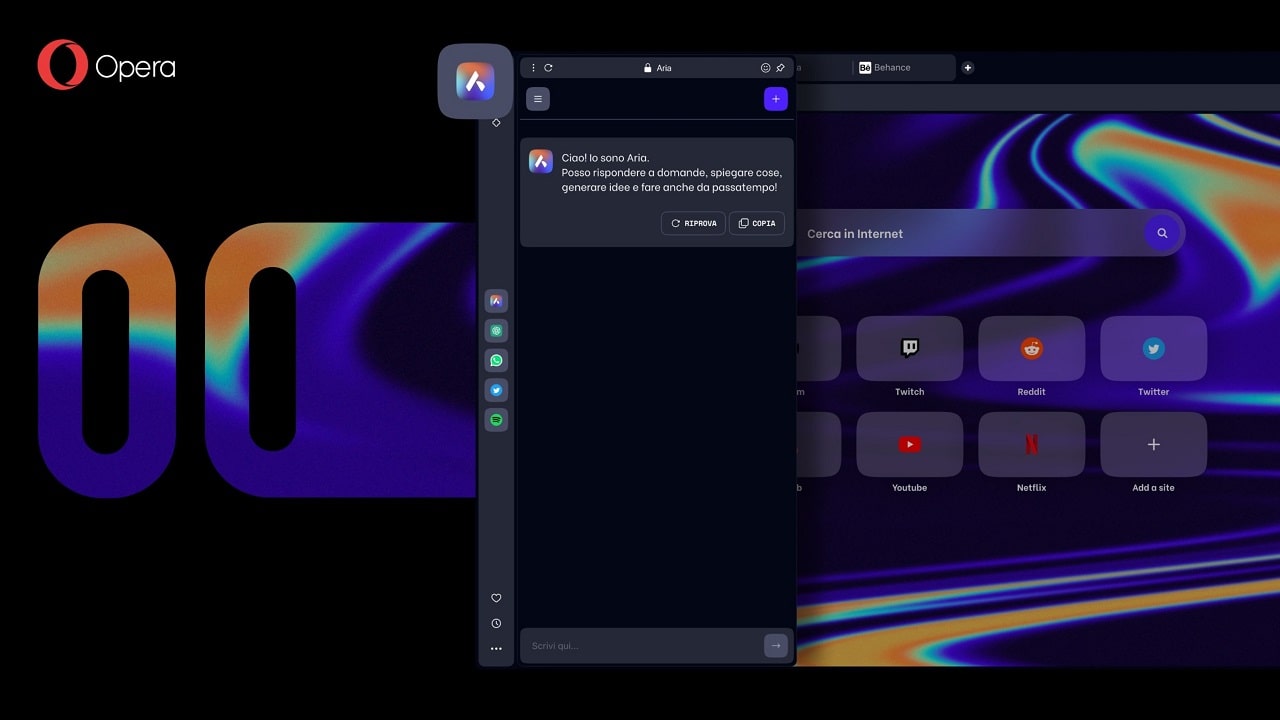

Come già accennato prima, l’AI generativa sta cambiando il modo di lavorare di molte aziende e liberi professionisti, che possono sfruttare la potenza di strumenti come ChatGPT per creare contenuti originali e personalizzati.

Tuttavia, l’uso strumenti basati su AI comporta anche dei rischi per la sicurezza (e per la privacy delle aziende). Queste devono essere consapevoli di come i loro dipendenti accedono e utilizzano questi strumenti. Infatti, in numerosi nostri articoli, vi abbiamo parlato di come ChatGPT può essere usato per scopi illeciti o dannosi, come la diffusione di informazioni false e persino attacchi cybercriminali. Ma, in modo decisamente più subdolo, l’AI può comportare un altro rischio: la perdita di dati sensibili.

- Belmonte, Luca (Autore)

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techprincess

🍎Nuovi iPad e accessori: cosa aspettarsi dall’evento Apple del 7 maggio

🍿Fallout: tutte le domande irrisolte alle quali la Stagione 2 dovrà rispondere

🛞Come scegliere gli pneumatici estivi per l’estate? I fattori da considerare

🤯Google licenzia 28 dipendenti per proteste contro il progetto Nimbus in Israele

✒️ La nostra imperdibile newsletter Caffellattech! Iscriviti qui

🎧 Ma lo sai che anche Fjona ha la sua newsletter?! Iscriviti a SuggeriPODCAST!

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

💌 Risolviamo i tuoi problemi di cuore con B1NARY

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸E trovi un po' di offerte interessanti su Telegram!